2024년 5월 6일

파인튜닝 (Fine-Tuning)

1. 파인튜닝 (Fine-Tuning)의 개념 및 필요성

| 개념 | 필요성 |

|---|---|

| 인공지능 모델이 특정 작업이나 도메인에 적합하도록 이미 훈련된 인공지능 모델에 특정 데이터셋을 적용하는 미세 조정 기법 | – 특정 작업/도메인에 적합한 모델 생성 – 적은 데이터셋으로 높은 학습 효과 – 신규 데이터에 대한 추론 성능 향상 |

- 파인 튜닝을 통해 학습 데이터가 적은 상황에서 특정 분야 인공지능 모델의 일반화 성능 향상

- 예를 들어, 멸종 위기종인 사자꼬리원숭이의 데이터셋이 부족하므로 사자꼬리원숭이의 유일한 특징 외에는 유사 원숭이 데이터셋을 사용하여 인공지능 모델 성능 향상

2. 파인튜닝 절차 및 AI 모델 별 파인튜닝 기법

(1) 파인튜닝 절차

| 절차도 |  | |

|---|---|---|

| 절차 | # | 단계 별 수행 내용 |

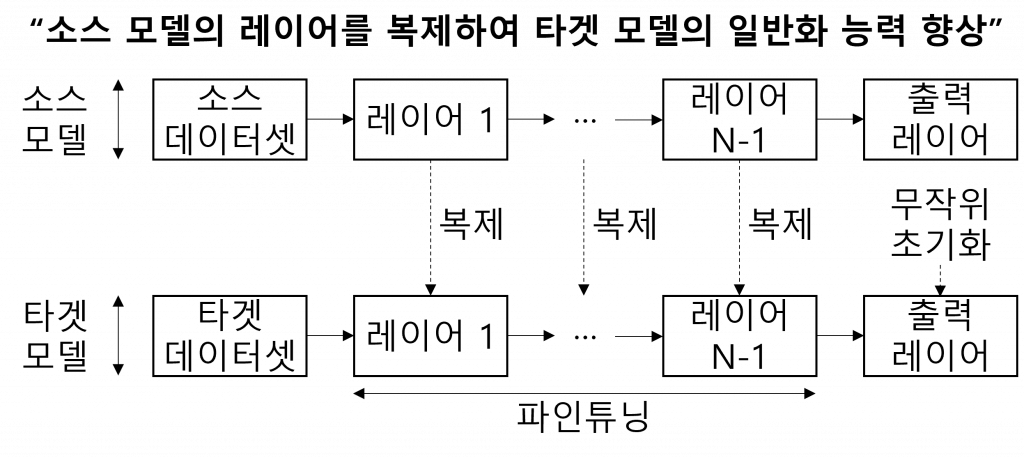

| ① | 소스 데이터셋에서 신경망 모델(소스 모델) 사전 훈련 | |

| ② | 새로운 신경망 모델(타겟 모델) 생성 시 출력 레이어를 제외한 레이어의 매개변수 복제 (복제되는 모델 매개변수에 소스 데이터셋에서 학습된 지식 포함) | |

| ③ | 출력 레이어를 타겟 모델에 추가 시 모델 매개변수를 무작위로 초기화 | |

| ④ | 타겟 데이터셋에서 타겟 모델 훈련 시 출력 레이어는 처음부터 훈련되지만, 다른 레이어의 매개변수는 소스 모델의 매개변수 기반 미세 조정 | |

(2) AI 모델 별 파인튜닝 기법

| AI 모델 | 파인튜닝 기법 | 상세 수행 |

|---|---|---|

| 컴퓨터 비전 모델 | 레이어 추가 | CNN 등 중간 Layer 추가로 신규 작업 특징 캡쳐 |

| 가중치 업데이트 | 신규 데이터셋 손실 최소화 하도록 조정 | |

| 데이터 증강 | 대규모 이미지셋 (ImageNet) 등 훈련된 모델 도입 | |

| 데이터 특성추출 | 신규 데이터셋의 특징 추출, 신규 모델 적용 | |

| 자연어 처리 모델 | 전이학습 | BERT, GPT 등 대규모 텍스트 코퍼스 모델 도입 |

| 토크나이저 튜닝 | 토크나이저 조정 또는 새로운 단어 학습, 개선 | |

| 도메인 어휘 추가 | 특정 도메인에 관련된 용어는 모델에 직접 추가 | |

| 음성 인식 모델 | 전이학습 | 공공 및 민간 데이터 개방된 음성인식 모델에 추가 |

| 음성 데이터 증강 | 음성데이터 잡음, 속도조절, 변조 기반 증강 | |

| 학습 모델 다양화 | 모델이 다양한 관점으로 학습하여 성능 일반화 | |

| 하이퍼파라미터 튜닝 | 학습률, 배치크기, 최적화 알고리즘 등 미세 조정 |

- 파인튜닝은 신규 모델 생성 시 대량의 학습 시간과 데이터셋이 불필요하고 성능 향상이 가능하지만, 학습률(Learning Rate)에 따른 과적합 등을 고려하여 사용 필요

3. 파인튜닝 사용 시 고려사항 및 대응 방안

| 고려사항 | 대응 방안 |

|---|---|

| – 데이터셋이 작을 경우, 과적합(Overfitting)으로 일반화 성능 저하 발생 가능 – 높은 학습률은 훈련된 파라미터 손상, 낮은 학습률은 학습 효과 저하 | – 다양한 훈련 데이터 확보, 정규화/표준화, Dropout 사용 – 분석 모델 유연성 및 충분한 학습데이터 확보, 교차 검증 (Cross Validation) 적용 |

- 완전 무작위 초기 파라미터를 적용하거나 일반적인 특징을 학습한 레이어의 파라미터 학습에 주의하여야 하며, 검색증강생성(RAG)을 적용하는 방안도 고려하여 적절한 파인튜닝을 통해 인공지능 모델 최적화 필요

[참고]

- Cambridge University Press, Dive into Deep Learning

- appen, 파인튜닝(Fine-tuning)이란?