2018년 12월 20일

seq2seq

1. 연속 단어의 응답 생성, seq2seq

- seq2seq: Sequence-to-Sequence

- 문장에 대한 응답을 생성하기 위해 여러 개의 Neural Network Cell을 조합하여 구성한 자연어 처리 모델

2. seq2seq의 구성도 및 구성요소

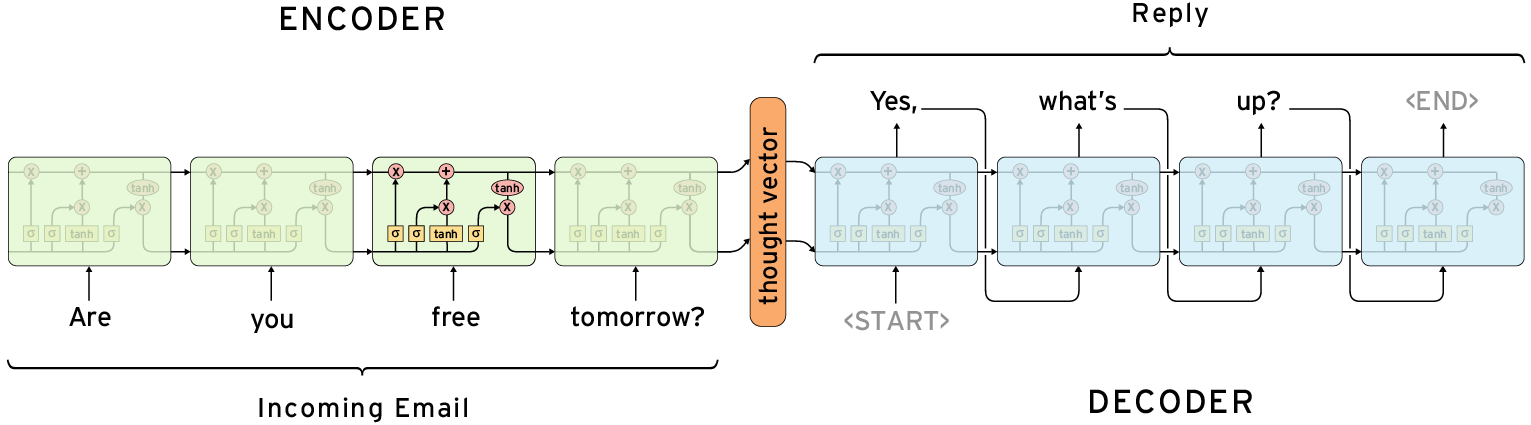

(1) seq2seq의 구성도

|

- Encoder 부분에서 입력 응답을 받아 하나의 hidden code 값으로 표현, Decoder에서는 hidden code와 start tag기반 적합한 결과 단어 추출

(2) seq2seq 구현을 위한 구성요소

| 구성요소 | 처리 대상 | 설명 |

|---|---|---|

| Encoder | – Source Language | – 입력 데이터 수신처리 – 주소 Stacked LSTM 활용 |

| Decoder | – Target Language | – 생성 데이터 출력처리 – 주소 Stacked LSTM 활용 |